영상 [Open DMQA Seminar] Model Evaluation Metrics 평가지표 및 추가적 4개의 평가지표

[Open DMQA Seminar] Model Evaluation Metrics - 영상 평가지표 공부하기

평가지표 종류

1. 회귀

- 특징

* 종속변수 Y와 이를 설명하기 위한 독립변수 X사이의 관계를 예측하는 모델이다.

* 실제 값(Y)와 모델이 예측한 값 사이의 차이와 관련된 지표를 통해 평가한다.

- 평가 지표 종류

* 크기 의존적 지표

* 비율 의존적 지표

Mean absolute error (MAE)

- 정의

* 실제값과 모델이 얘측한 값 차이의 절대값들의 평균 값

- 특징

* 절대값을 통해 양의 에러와 음의 에러가 상쇄되는 효과를 제거한다.

* 실제 데이터와 통일된 단위로 분석이 직관적이라는 장점이 있다.

* 실제 값과 비교해 값이 보다 크거나 작은지 파악이 어렵다.

문제예시

2. Mean squared error

- 정의

* 실제값과 모델이 측한 값 차이를 제곱한 값들의 평균 값

- 특징

* 실제 값과 예측값 차이(= 에러)를 제곱한다.

* 에러 < 1 : 원래의 에러

* 에러 >= 1 : 왜곡 발생

* 실제 데이터의 단위가 통일되어있지 않아 추가적인 해석이 필요하다

* 실제 값과 비교해 예측 값이 보다 크거나 작은지 파악이 어렵다.

문제예시

3. Root mean squared log error(RMSLE)

- 정의

* RMSE에서 로그를 취해준 지표

- 특징

* 직관적이지 않아 에러를 통한 해석이 어렵다.

* RMSE에서 값의 절대적 크기에 영향을 많이 받는 단점을 해결하기 위한 상대적 에러이다.

* 실제 값보다 작게 예측을 진행하는 경우 더욱 큰 패널티를 부여하는 지표이다.

문제예시

4. Mean absolute percentage error(MAPE)

- 정의

*MAE를 비율로 변환하여 표현하는 값

- 특징

* 단위의 차이가 크게 나타났을 때 해석이 어려웠던 문제점 해결

* 실제 값에 0이포함된 경우 사용불가

문제예시

5. 결정계수( R² )

- 정의

* 데이터의 분산을 기반으로 한 평가 지표로 결정계수라고 불린다.

- 특징

* 데이터 크기에 따라 영향을 받지 않은 평가지표

* 다른 지표들과는 큰 값을 가질수록 좋은 성능이다.

* 예측값이 평균보다 큰 오차를 보인다면 음의값을 보인.

그래프 자료

문제예시

2. 분류

- 특징

* 주어진 데이터들을 각각 속하는 클래스로 나누어주는 문제

* 실제 데이터와 클래스와 모델이 예측한 클래스가 일치하는 비율을 통해 모델을 평가한다.

혼동행렬(Confusion matrix)

* 실제 정답과 모델의 예측 결과를 행렬의 형태로 표기한 것이다.

* True/False: 실제 정답과 모델의 예측결과가 동일한지/동일하지 않은지 표현.

* Positive / Negative : 모델의 예측 결과에 대한 표현

1.정확도(Accuracy)

- 특징

* 전체 데이터 중 올바르게 분류가 이루어진 데이터 비율

* 가장 직관적 평가지표

* 데이터 사이의 불균형의 문제가 있을 시 적절하지 못한 평가지표

문제예시

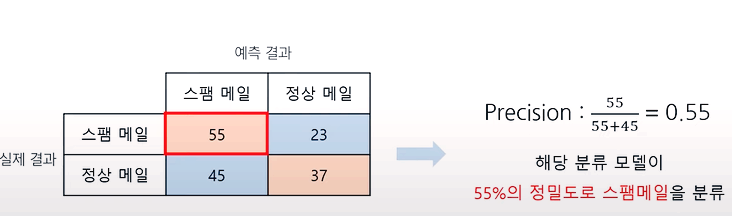

2. 정밀도(Precision)

- 특징

* 실제결과와 예측결과 모두 Positive 인 데이터 / 예측결과가 Positive인 데이터

* Positive로 예측했지만 실제 결과가 Negative일 때 큰 문제가 생기는 상황에서 사용되는 지표이다.

예시문제

3. 재현율(Recall)

- 특징

* 예측결과와 실제 결과 모두 positive인 데이터 / 실제 결과가 positive인 데이터

* 실제 값이 positive일 때, 모델의 예측 값도 positive인 경우가 중요할 때 사용되는 지표

4. Fβ - score

- 특징

* 정밀도와 재현율의 trade-off관계로 두 값을 동시에 높게 할 수 없다.

* 정밀도와 재현율의 가중조화평균을 활용해 정밀도와 재현율의 값을 하나의 값으로 표현한 지표이다.

* 정밀도에 주어진 가중치를 β라고 하며, β = 1인 경우를 F1 - score를 의미한다.

* 가중조화평균: 일련의 숫자의 조화 평균은 값의 수를 각 값의 역수로 나눈 다음 그 결과의 역수를 취하여 계산됩니다. 간단히 말해서, 조화 평균은 값의 역수에 대한 산술 평균의 역수입니다.

예시문제

사용 예시

5. 임계값(Threshold)

- 특징

* 특정 클래스로 분류하기 위한 기준치이다.

* 이진분류에서는 기본적으로 0.5로 설정한다.

* 임계값 설정에 따라 재현율 값이 달라져 정밀도와 재현율을 균형있게 예측하는 적절한 임계값을 설정한다.

임계값과 정밀도 그리고 재현율의 상관관계

* 임계값을 높게 선정하게되면 negative로 예측하는 비율이 많아져 정밀도가 증가한다.

* 임계값을 낮게 선정하게되면 positive로 예측하는 비율이 많아져 재현율이 증가한다.

6. ROC curve & AUC

- 특징

* ROC curve : X축을 Fall-out 지표, Y축을 Recall 지표로 하는 그래프로 표현하는 방식이다.

* Fall-out: 실제결과가 negative이고 실제 결과도 negative일 때 / 실제 결과가 negative인 데이터

* AUC: ROC curve를 수치화한 값으로 ROC curve의 면적이다.

영상에서 제시된 평가지표 외에 또 다른 평가지표

1. Average Precision(AP)

* 인식 알고리즘의 성능을 하나의 값으로 표현한 것이다.

* precision-recall 그래프에서 그래프 선 아래쪽의 면적으로 계산된다.

2. PR curve

- 특징

* x축 Recall y축은 Precision로 서로 Trade-off하는 관계이다 .

* 파란선은 mAP(Mean Average Presion)표시이다. - mAP는 AP값들의 평균이다.

* 회색선들은 AP( Average Presion)표시이다.

3. IOU

* Ground-truth bounding box : 실제 객체 위치(초록색 박스)

* Predicted bounding box : 알고리즘이 찾은 객체 위치(빨간색 박스)

- 특징

* Intersection : 교집합. predicted bounding box와 ground-truth bounding box가 겹치는 부분 (overlap된 부분)

* Union : 합집합. predicted bounding box와 ground-truth bounding box를 모두 둘러싼 부분

* Intersection Over Union (IOU) : Intersection을 Union으로 나눈 비율

* IOU값이 0.5 이상이면 'good' prediction, 잘 예측한 것으로 본다.

* threshold를 0.5로 설정하는 경우가 많다.

4. PSNR (Peak Signal-to-noise ratio)

특징

* PSNR은 영상 화질 손실양을 평가하기 위해 사용되는 지표입니다.

* 이미지 저장, 전송, 압축, 영상 처리 등에서 영상 화질이 바뀌었을 때 사용됩니다.

* MSE는 작을수록 좋고, PSNR은 클수록 좋습니다.( PSNR이 클수록 손실양이 적고 퀄리티가 좋다는 것을 의미합니다.)

* MSE의 Scale을 변경(Normalization) 한 것이 PSNR라고 생각 할 수 있습니다.

그림예시

출처

[Open DMQA Seminar] Model Evaluation Metrics

[개념정리] IOU (Intersection Over Union)와 mAP (mean Average Precision) (tistory.com)

mAP(Mean Average Precision) 정리 (tistory.com)

[통계] 딥러닝 모델 성능 평가 지표 - mAP (tistory.com)