카테고리 없음

BERT 간단 논문 리뷰

수닝이

2024. 7. 12. 17:58

특징

* Bert에서는 mask된 토큰만 예측한다.

Task1

Bert는 양방향으로 훈련을 진행한다. 이를 위해 전체 Sequential에서 랜덤하게 15%를 안 보이도록 마스킹한다. 그 다음 마스킹된 데이터를 예측하는 것이다.

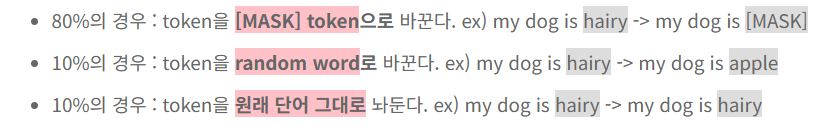

pretraining 과 fine tuning의 mismatch해결법

보이는 것과 같이 80%는 안 보이게 마스킹, 10%는 다른 단어로 대체 그리고 나머지 10%는 원래 단어 그대로 놔둔다.

Task2

NSP를 통한 다음 문장 예측

- 50%는 이어진 문장을 배치한다.

- 만약 서로 이어진 문장일 경우 라밸 1을 아닐 경우 라벨 0을 넣는다.

- pretraning을 통해 다음 문장을 예측할 수 있다.

4개의 구조

전 구조의 공통점 : 마지막 layer에 finetuning 한 층만 올린다.

1번 구조

- 2개의 다른 sentence를 받아서 특정한 task에 속하는 지 아닌지 확인하는 모델구조

2번구조

- 질문과 본문 두 문장을 받아 답을 생성해주는 모델이다.

- output은 범주를 예측하느냐, 새로운 문장을 생성하느냐에따라 달라진다.

3번구조

- 하나의 문장을 받아 하나의 답을 내는 역할을 한다.

- EX. 감정분석

4번구조

- 하나의 문장을 받아 각각의 토큰 별로 답을 내놔주는 역할을 한다.

- EX. 형태소 분석

BERT(base) VS. No NSP

BERT(base) : Next Sentence Prediction 존재

No NSP : Bert에서 Next Sentence Prediction이 없다.

- 간단한 문장에대해선 큰 차이가 없다.

- 두 문장 이상을 이해해야하는 부분(QNLI)에서는 0.6%정도 차이가 난다. 즉, 여러 문장이 존재할 시 다음 문장을 예측하는 것이 큰 도움이 된다.

모델크기에 따른 결과

- 모델 구조가 커질 수록 결과가 좋아진다.

결과

Fintuning X

Embeddings

- 처음 것만 쓰겠다는 말이다.

- 성능이 5% 정도 떨어진 모습을 보인다.

Last Hidden

- 마지막 결과만 쓰겠다는 말이다.

Concact Last Four Hidden

- 마지막 4개의 층에서 나온 결과를 결합했을 때의 결과를 사용한다는 말이다.

- 전부 사용했을 때보다 마지막 4개를 결합했을 때 Fintuning 했을 때의 결과와 비슷하게 나왔다.

출처